多家廠商的 AI 之戰已經開打一段時間,而開創 AI 語音助理先河的 Apple,似乎是有些靜悄悄還在觀望的狀態。不過稍早前官方因應各領域身心障礙的使用者,也打造出多款專屬的輔助功能,其中有包含語音與視覺相關的「Personal Voice」、「Live Speech」與放大鏡延伸出的「Point and Speak」三款;以及針對認知功能障礙的族群推出的簡潔介面「Assistive Acess」等。

而這裡特別要說的是,Apple 其實在部分功能也用上了機器學習等 AI 技術,算是惦惦吃三碗公的類型(?);另外,部分功能如 「Personal Voice」光看字面解釋的話,不僅可以幫助到需要的族群,甚至還能在條件允許之下,實現一些意想不到的感動時刻(?)

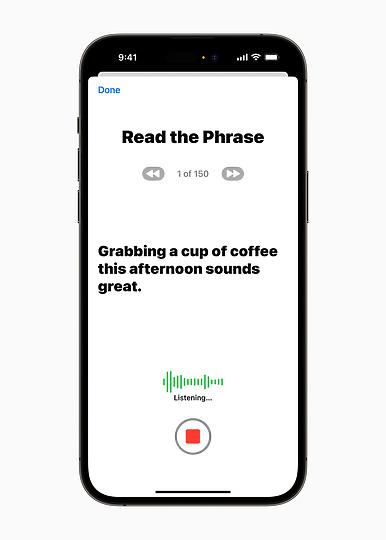

首先要介紹的自然是本次最大的亮點「Personal Voice」功能。簡單來說,使用者在朗讀約 15 分鐘,由 iPhone 或 iPad 隨機且自動生成的文本後,裝置端就會透過 AI 技術創造並模擬出與錄音者相似的語音,如此就能搭配本次的另一項功能「Live Speech」。

另外,要是先請長輩使用這個功能,哪天真的等到分離那一刻,就不用重複播放以前的影片或是錄音,可以直接透過「Personal Voice」模擬出不同情境,某種程度上有點像現在 AI 模擬不同人聲的功能?但官方這邊是沒有詳細解說技術就是。但從安全性來看,除非是手機不見,不然自己錄製的聲音,在一般狀態下其實也很難被人盜用。除非有個天才駭客把資訊都盜取,但這個狀況就相對極端一些。

- Live Speech

- Live Speech

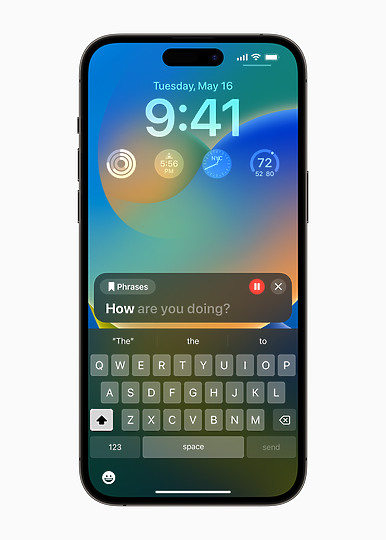

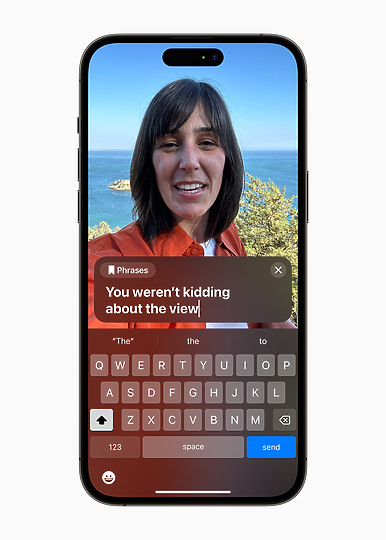

如果要說「Personal Voice」是前端功能的話,那麼「Live Speech」就可視為應用的工具了。有需要的使用者可以透過打字方式將想說的話紀錄,在透過電話、FaceTime 通話時,就能讓裝置直接朗誦出記錄下來的文字;另外,也能先將常用的語句儲存下來以便快速使用。

所以整個情境其實可以這樣解釋,首先透過「Personal Voice」模擬出像是自己的聲音,再透過「Live Speech」的方式來與他人溝通。但我自己好奇萬一是瘖啞人士的話聲音會如何來,需要請別人錄製?還是裝置會有預設的語音?這點就要等功能實裝時再來檢視。

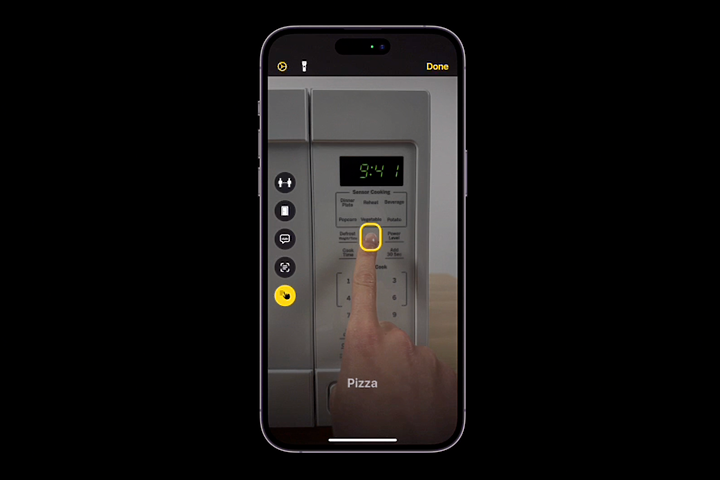

緊接著是以放大鏡功能延伸出的「Point and Speak」,這項功能則是針對視覺障礙的朋友設計,整體來說是透過相機、光學雷達掃瞄儀以及裝置端的機器學習,來達成使用者手指點到哪,就能朗誦出對應的文字,這邊則是以微波爐來做示範,建議可至官方連結實際看看影片的效果!

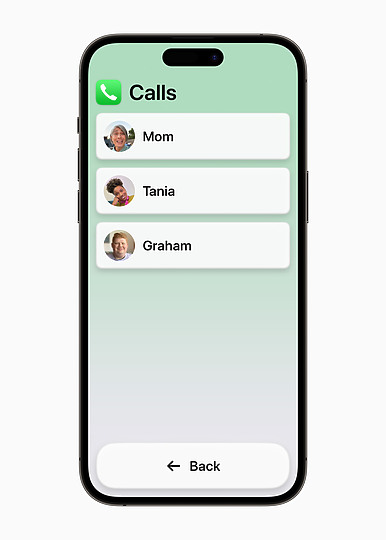

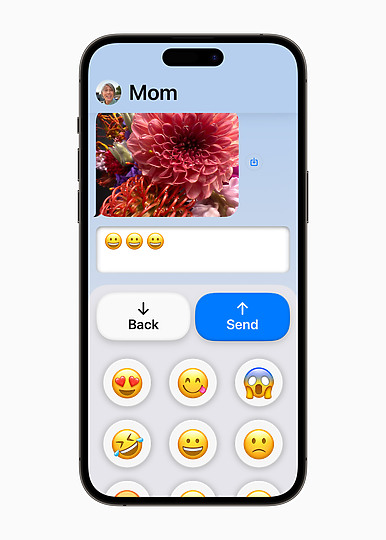

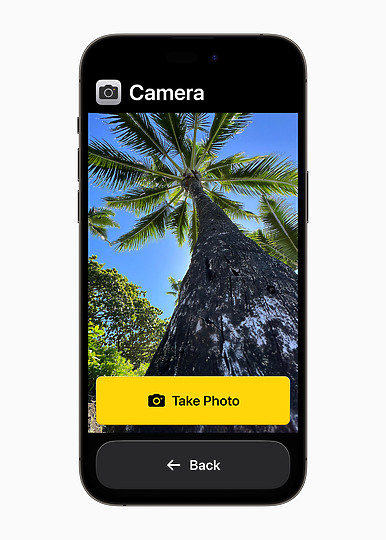

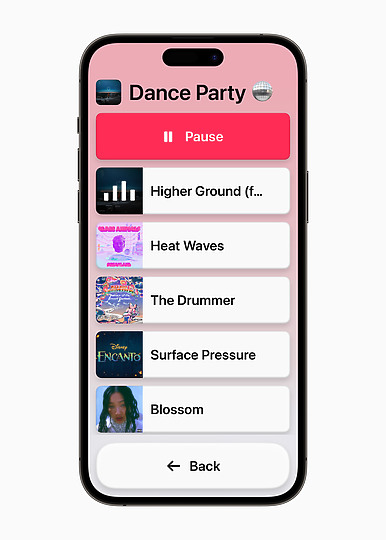

講完了跟語音相關的輔助功能,接下來則是針對認知障礙族群設計的「Assistive Acess」。一言以蔽之,其實可以把這項功能當成目前不少手機都有的簡易模式,只是核心功能還是都完整保持,就是一個去蕪存菁的狀態,如此就能簡易且快速的無礙使用 iPhone 或是 iPad 裝置。

首先在主畫面上,就能看到有著單純圖示,或是以文字為主的兩種介面,共通點則是真的相當簡易.....要是 iPhone 有出功能型手機,也許就會長成這樣吧

- 通話

- 訊息

- 相機

- 照片

- 音樂

這邊也附上官方目前釋出的相關圖片,可以看到有通話、訊息、相機、照片與音樂共五大項,都是以簡潔到不行的 UI 介面來做打造。其中音樂介面其實頗為相似早期的 iPhone 或是 iPod Touch。

目前這幾項輔助功能都預計在今年稍晚時會正式推出,屆時再來做個詳細介紹,尤其是「Personal Voice」真的蠻讓人感興趣的